2025. 2. 19. 10:00ㆍ특집

|글. 오연주 (한국지능정보사회진흥원 인공지능정책본부 수석연구원)|

올 한 해 선거를 치른 세계 각국의

소셜미디어는 AI가 만들어낸

각종 허위조작정보로 몸살을 앓았다.

언론은 가짜뉴스를

구분하느라 진땀을 뺐다.

이 시점에서 지난 선거를 돌아보며

문득 떠오르는 질문이 있다.

우리의 걱정대로

과연 AI는 전 세계 선거에

중차대한 영향을 미쳤을까?

선거의 어떤 부분에 개입하여

얼마나 위협적인 영향을 주었을까?

영국 앨런튜링연구소가

같은 고민으로 연구를 진행하여

두 개의 보고서를 발표했다.

슈퍼 선거의 해,

AI의 선거 개입은 실제

어느 정도였는지 함께 확인해 보자.

11월 5일 열린 미국 대선을 끝으로 2024년 예정된 전 세계 주요 선거가 마무리되었다. 2024년은 70여 개국에서 전 세계 인구 절반 이상이 투표하는 ‘슈퍼 선거의 해’이자, 최근 2년 동안 급속히 성장한 생성형 AI의 영향이 본격적으로 검증될 ‘AI 선거의 해’였다. ‘슈퍼 선거의 해’이자 ‘AI 선거의 해’를 맞아 AI가 민주주의를 위협할 것이라는 우려가 제기되었고, 선거에서의 AI 활용에 대한 제도 마련 및 유권자 교육 등의 조치에 대한 필요성이 강조되었다(Wirtschafter, 2024). 한편 마이크로소프트, 오픈AI, 구글 등 20여 개의 주요 테크기업은 2월에 열린 독일 뮌헨 안보회의에서 AI 기술을 악용해 선거에 영향을 끼치는 행위에 공동 대응하기 위한 협정을 맺기도 했다(A Tech Accord, 2024).

최근에 있었던 주요 선거를 되돌아볼 때, AI는 우려했던 만큼 선거에 영향을 미쳤을까? 영국 앨런튜링연구소의 신흥기술안보센터(Centre for Emerging Technology and Security, CETaS)가 이 질문에 답하는 두 개의 보고서를 발표했다.[1] 5월에 발표된 첫 번째 보고서 「AI-Enabled Influence Operations: The Threat to the UK General Election」는 2023년 1월부터 2024년 5월까지 열린 전 세계 112개국 선거 과정에서 있었던 AI의 개입 사례 및 그 영향을 분석했다(Stockwell 외, 2024). 9월에 발표된 두 번째 보고서 「AI-Enabled Influence Operations: Threat Analysis of the 2024 UK and European Elections」는 영국과 프랑스의 총선, 유럽의회 선거에서 발견한 AI 위협 양상을 검토했다(Stockwell, 2024). 본 글에서는 두 보고서의 주요 결과를 살펴보고, AI의 선거 개입 위협에 대한 대응으로 미디어 리터러시 교육의 방향을 제시한다.

|

AI가 선거에 미친 영향:

선거 운동, 정보, 인프라 위협

|

두 보고서의 핵심적인 결론은 AI가 선거에 미친 영향이 우려보다 제한적이었다는 것이다. 첫 번째 보고서는 112개국 선거 중 19개 선거에서 AI의 개입이 확인되었으나, 여론조사와 비교했을 때 AI가 실제 선거 결과를 바꾸지는 못한 것으로 드러났다. 후속 보고서는 영국 총선에서 16개의 개입 사례, 프랑스 총선과 유럽의회 선거에서 11개의 개입 사례를 확인했는데, 다른 국가들과 마찬가지로 선거 결과에 유의미한 영향을 미치지 못했다고 평가했다. AI가 선거 결과를 좌우하지는 않았지만, 민주주의 시스템 전반에 2차 위험(second-order risk)을 일으켰다. 보고서는 이러한 위험을 '① ‘선거 운동 위협, ② 선거 정보 위협, ③ 선거 인프라 위협’이라는 세 가지 범주로 분류하고 각각의 특징과 영향을 분석했다.

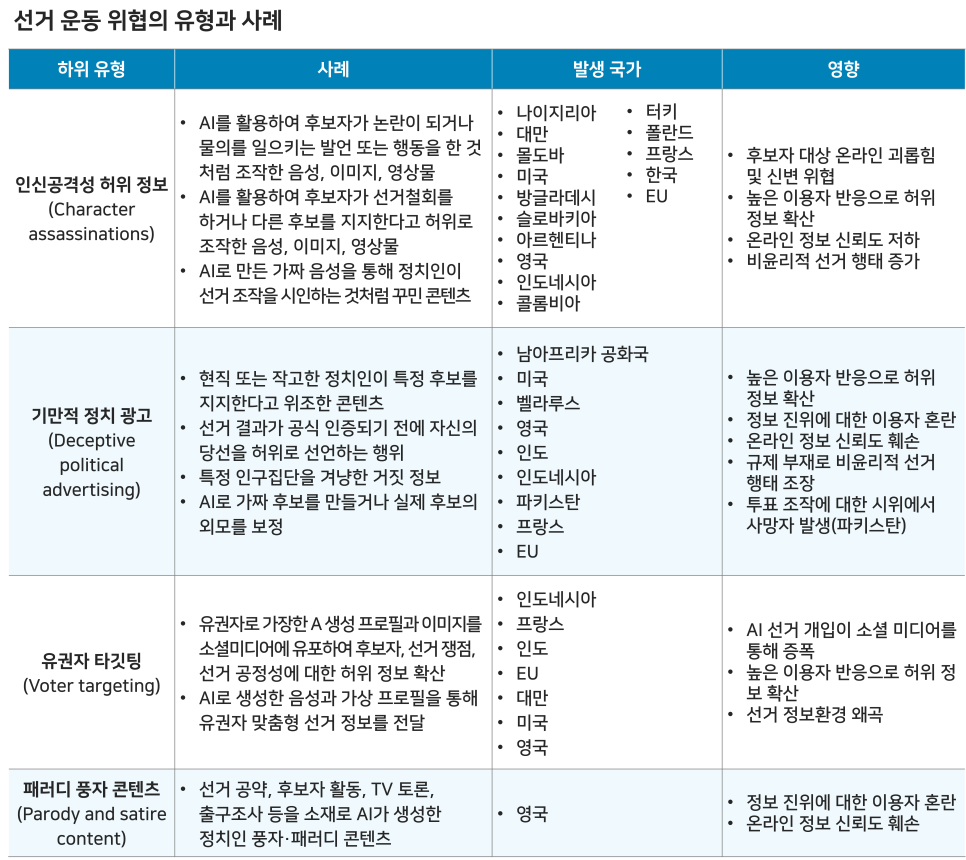

① 선거 운동 위협은 정치 후보자 또는 특정 정치적 이슈와 관련하여 유권자의 태도나 행동을 조작하기 위해 설계된 AI 활용이다. 구체적으로는 정치인이 논란이 될 만한 발언이나 행동을 했다고 조작하거나 선거 조작을 시인하는 것처럼 꾸미는 등 인신공격성 허위정보가 있었고, 현직 또는 작고한 정치인의 지지 선언을 위조하거나 공식 인증 전에 당선을 허위로 선언하는 등 기만적인 정치 광고도 있었다.

또한, AI로 만든 가짜 유권자 프로필로 특정 집단을 겨냥해 선거 관련 허위정보를 퍼뜨리는 타깃팅이 시도되었으며, 선거 쟁점이나 TV 토론, 출구조사 등을 풍자한다는 명목으로 허위정보를 유포하는 사례도 발견됐다. 이러한 위협들은 선거 결과를 좌우하지는 못했으나, 정치인 대상 혐오 조장과 안전위협, 선거 과정 전반의 신뢰 훼손이라는 부작용을 낳았다.

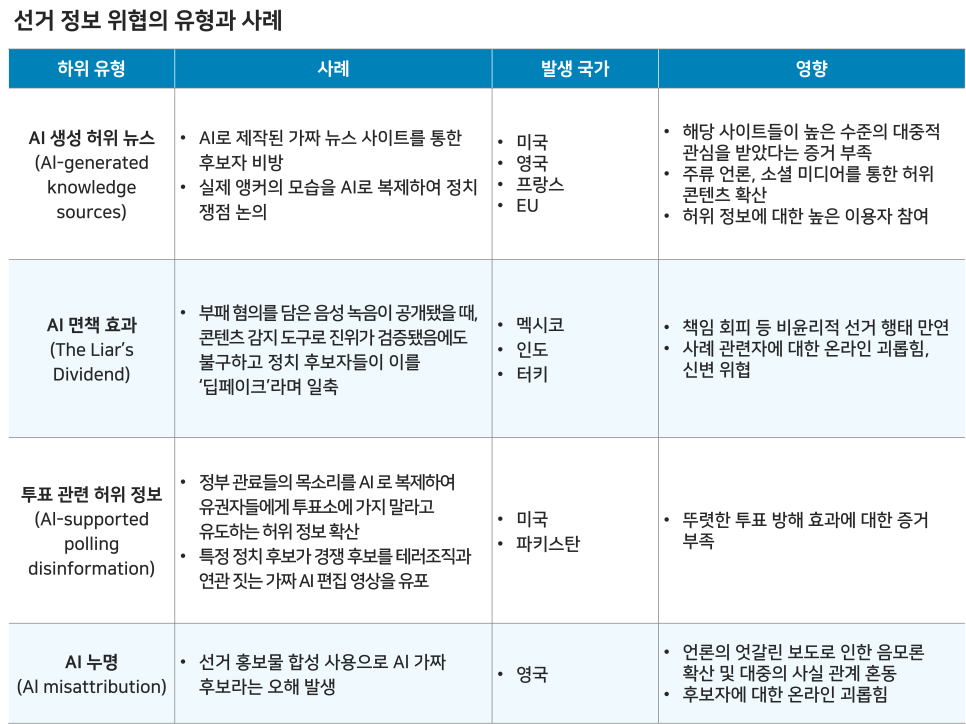

② 선거 정보 위협은 유권자들에게 혼란을 일으키고 선거 결과의 신뢰성을 손상하기 위해 선거 관련 정보 환경을 교란하는 AI 활용을 말한다. 러시아 정부 소속으로 추정되는 허위정보 유포 조직인 ‘Doppel ganger’가 ‘The London Crier’와 같은 가짜 언론을 사칭하며 AI로 허위 뉴스를 생산하는 등의 조직적인 허위정보 유포가 있었고, 정치인들이 자신들의 부패 혐의 등이 담긴 증거물이 공개됐을 때 이를 ‘AI 딥페이크’라고 주장하며 책임을 회피하는 현상이 나타났다. 또한 정부 관료의 목소리를 AI로 복제해 투표 거부를 선동하거나 챗봇으로 잘못된 투표 요건을 안내하는 등 투표 참여를 방해하는 시도가 있었으며, 선거 홍보물에 AI 합성을 사용했다는 이유로 특정 후보가 ‘AI 가짜 후보’라는 누명을 쓰는 사례도 발생했다. 선거 운동 위협과 마찬가지로 선거 정보 위협들도 선거 결과에 직접적인 영향을 미치지는 않았으나, 허위정보의 확산과 온라인 괴롭힘을 초래했고 디지털 정보 환경과 선거 과정 전반에 대한 신뢰를 훼손시켰다.

③ 선거 인프라 위협은 선거 결과를 조작하거나 선거 결과에 대한 신뢰를 훼손하기 위해 선거 과정의 무결성을 책임지는 시스템과 관계자들을 겨냥하는 AI 활용을 의미한다. 선거인 명부나 투표 집계기 등 선거 관련 디지털 인프라가 늘어나면서 사이버 공격의 위험도 증가했는데, ‘WormGPT’와 같은 상업용 AI 도구들이 피싱 공격의 규모와 성공률을 높이는 데 활용될 수 있다는 우려가 제기됐다. 현재까지 AI를 활용한 선거 인프라 공격 사례는 보고된 바 없으나, 선거 관련 사이버 공격은 꾸준히 발생하고 있다. 2023년 영국 선거관리위원회가 해킹을 당해 2014~2022년 등록 유권자의 개인정보가 유출된 바 있으며, 2021년에는 중국 정부 연계 조직이 영국 국회의원들의 이메일을 타깃팅한 사례도 있었다. 2023년과 2024년 초 사이 선거 관련 사이버 공격이 급증함에 따라, 향후 AI 시스템이 이러한 공격을 지원할 가능성이 제기되었다.

|

AI의 선거 개입,

대응 방안과 미디어 리터러시의 역할

|

두 보고서에서는 AI를 활용한 선거 개입에 대응하기 위한 세 가지 측면의 방안을 제시했다.

첫째, AI 허위정보에 대한 대응 지침을 마련하고 관련 주체들의 대응 역량을 강화하는 것이다. 구체적으로는 ‘AI 공정 사용’ 협약 체결, 언론사 대상 딥페이크 탐지 도구 제공, 다국어 대중 인식 제고 캠페인 등을 권고했다.

둘째, 법적 규제 측면에서는 AI를 이용한 허위 지지 선언 등에 대한 명예훼손법 적용을 명확히 하고, 정당의 디지털 선거 자산에 대한 필수 인증제를 도입할 것을 제안했다.

셋째, 선거 대비 태세 강화를 위해 선거 관리자, 언론사, 소셜미디어 플랫폼이 참여하는 AI 위협 대응 시뮬레이션을 실시하고, 정부와 연구기관, 테크기업, 언론사가 협력하여 AI 선거 자료를 수집 및 분석하는 통합 저장소를 구축할 것을 강조했다.

보고서에서는 미디어 리터러시의 역할에 대한 언급은 없었으나, 최근의 조사 및 연구들은 AI 허위정보 대응에 있어 시민들의 리터러시 역량 향상이 시급한 과제임을 보여준다. 앨런튜링연구소가 2004년 5~6월 영국 성인을 대상으로 한 조사에 따르면 응답자의 17.4%가 딥페이크 식별에 자신감을 보였지만, 16.5%는 그렇지 않다고 답했다. 응답자의 대다수인 66.1%는 딥페이크를 알아낼 수 있을지 확신할 수 없다고 답했다(Sippy 외, 2024). 주목할 만한 점은 여러 실험 연구들이 미디어 리터러시 교육이 딥페이크 기반 허위정보의 식별과 그 영향력 감소에 효과가 있음을 입증하고 있다는 것이다(El Mokadem, 2023; Hwang 외, 2021).

AI 허위정보의 영향력을 완화하는 데 있어 미디어 리터러시 교육은 필수적이나 두 가지 도전 과제에 직면해 있다.

첫째, 다양한 교육 프로그램이 개발되었고 그 효과가 입증되었음에도 실제 활용도는 낮은 수준에 머물러 있다(Enock, 2024). 선거에서의 AI 활용은 시민 대다수에 영향을 미치나, 공교육을 마친 성인들이 미디어 리터러시 교육을 받을 수 있는 기회는 매우 제한적이다. 허위정보가 주로 소셜미디어를 통해 유통되는 현실을 고려할 때, 정보를 소비하는 바로 그 플랫폼에서 교육이 이루어지는 것이 효과적일 수 있다.

둘째, 교육의 관점도 개선이 필요하다. 비판적 미디어 리터러시의 관점에서 보면, 현재의 교육은 개별 콘텐츠의 진위 판단이라는 기술적 능력 향상에만 초점을 맞추고 있다. 이보다 중요한 것은 허위정보의 생산과 유통구조, 그 배후의 이해관계, 그리고 이것이 민주주의와 시민사회에 미치는 영향을 이해하는 것이다. 따라서 미디어 리터러시 교육은 단순한 식별 훈련을 넘어, 정보 생태계의 구조적 문제를 인식하고 이에 대한 비판적 성찰을 도모하는 방향으로 나아갈 필요가 있다.

[1] 신흥기술안보센터는 세 편의 보고서 시리즈를 통해 주요 선거에서의 AI 영향력을 분석하고 있다. 본 글에서 소개한 5월과 9월에 발표된 두 보고서에 이어 미국 대선에서의 AI 위협 사례를 다룬 최종 보고서가 발간될 예정이다.

참고문헌

A tech accord to combat deceptive use of AI in 2024 elections. (2024. 2. 16). AI Elections Accord. https://www.aielectionsaccord.com/uploads/2024/02/A-Tech-Accord-to-Combat-Deceptive-Use-of-AI-in-2024-Elections.FINAL_.pdf (2024. 11. 10. 최종 접속)

Enock, F. (2024. 6. 3.). Beyond the deepfake: five Turing experts look at how AI is impacting democracy. https://www.turing.ac.uk/blog/beyond-deepfake-five-turing-experts-look-how-ai-impacting-democracy (2024. 11. 10. 최종 접속)

Hwang, Y., Ryu, J. Y., Jeong, S. (2021.). Effects of disinformation using deepfake: The protective effect of media literacy education. Cyberpsychology, Behavior and Social Networking, 24(3), 188?193.

El Mokadem, S. S. (2023). The effect of media literacy on misinformation and deep fake video detection. Arab Media & Society. https://www.arabmediasociety.com/the-effect-of-media-literacy-on-misinformation-and-deep-fake-video-detection/ (2024. 11. 10. 최종 접속)

Sippy, T., Enock, F. E., Bright, J., & Margetts, H. (2024). Behind the deepfake: 8% create; 90% concerned. https://www.turing.ac.uk/news/publications/behind-deepfake-8-create-90-concerned (2024. 11. 10. 최종 접속)

Stockwell, S. (2024). AI-enabled influence operation: Threat analysis of the 2024 UK and European Elections. https://cetas.turing.ac.uk/publications/ai-enabled-influence-operations-threat-analysis-2024-uk-and-european-elections (2024. 11. 10. 최종 접속)

Stockwell, S., Hughes, M., Swatton, P., & Bishop, K. (2024). AI-enabled influence operations: The threat to the UK General Election. The Alan Turing Institute. https://cetas.turing.ac.uk/publications/ai-enabled-influence-operations-threat-uk-general-election (2024. 11. 10. 최종 접속)

Wirtschafter, V. (2024. 1. 30.). The impact of generative AI in a global election year. Brookings Institution. https://www.brookings.edu/articles/the-impact-of-generative-ai-in-a-global-election-year/ (2024. 11. 10. 최종 접속)

'특집' 카테고리의 다른 글

| 카타르시스를 주는 '가짜'를 어떻게 대비할 것인가 (0) | 2025.02.26 |

|---|---|

| 정치·시사 유튜브 전성시대, 바르게 이용하기 (0) | 2025.02.18 |

| 선거판 흔드는 AI 허위조작정보와 대응 방법 (2) | 2025.02.18 |

| 갈등 보도는 어떻게 읽어야 하는가 (2) | 2024.12.25 |

| 누구나 AI 활용 시대, AI 리터러시 교육 서둘러야 (0) | 2024.02.28 |